前言

工作中偶爾會遇到文件去重的事情,收到一大堆文件,名稱各不相同,分析文件的時候發現有不少重復的文件,導致工作效率低下,那么,這里就寫了一個python腳本實現文件去重功能

工作原理

腳本會檢查你給出的文件路徑下的所有文件,然后計算每個文件的md5值,并將其加入到一個列表中。

- 如果某文件的md5值不在列表中,就認定其是我們需要的文件,腳本會在桌面新建一個名為“去重結果”的文件夾,并將其復制到里面去。

- 如果某文件的md5值在列表中,就認定其不是我們需要的文件,不對其做任何處理。

- 代碼可以直接運行,無需做任何修改(除了安裝可能缺少的庫文件)

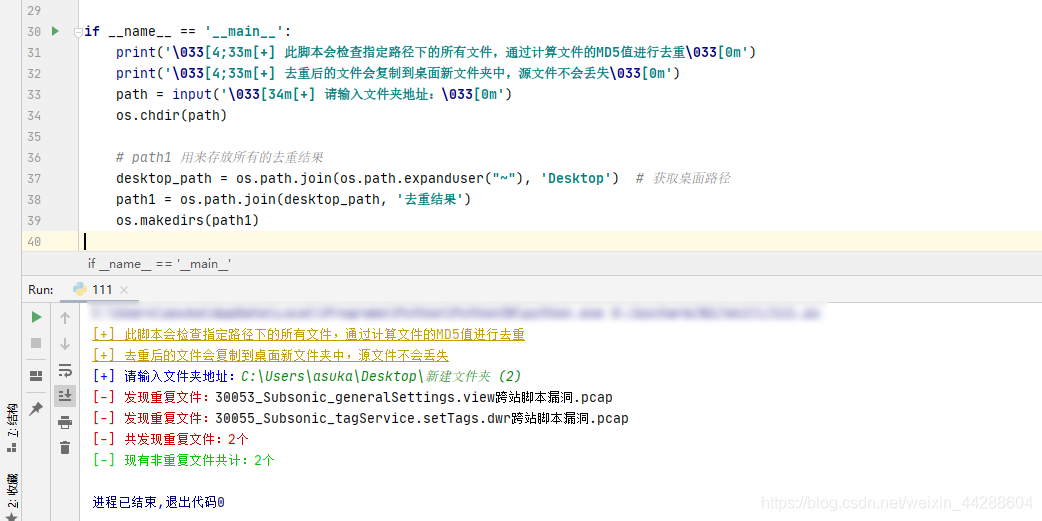

代碼

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

|

import osimport shutilimport hashlib# 對文件去重# 計算每個文件的md5值,據此進行去重def only_one(test_path): md5_list = [] count = 0 for current_folder, list_folders, files in os.walk(test_path): for file in files: file_path = current_folder + '\\' + file # 獲取每個文件的路徑 f = open(file_path, 'rb') # 開始計算每個文件的md5值 md5obj = hashlib.md5() md5obj.update(f.read()) get_hash = md5obj.hexdigest() f.close() md5_value = str(get_hash).upper() # 開始去重 if md5_value in md5_list: # 如果這個文件的md5值曾經出現過,就不對它做任何處理 count += 1 print('\033[31m[-] 發現重復文件:\033[0m' + str(file)) else: md5_list.append(md5_value) # 如果這個文件的md5值不存在列表中,就添加進列表中 shutil.copy(file_path, path1) print('\033[31m[-] 共發現重復文件:{}個\033[0m'.format(count))if __name__ == '__main__': print('\033[4;33m[+] 此腳本會檢查指定路徑下的所有文件,通過計算文件的md5值進行去重\033[0m') print('\033[4;33m[+] 去重后的文件會復制到桌面新文件夾中,源文件不會丟失\033[0m') path = input('\033[34m[+] 請輸入文件夾地址:\033[0m') os.chdir(path) # path1 用來存放所有的去重結果 desktop_path = os.path.join(os.path.expanduser("~"), 'desktop') # 獲取桌面路徑 path1 = os.path.join(desktop_path, '去重結果') os.makedirs(path1) only_one(path) print('\033[32m[-] 現有非重復文件共計:{}個\033[0m'.format(len(os.listdir(path1)))) |

到此這篇關于python實現md5進行文件去重的示例代碼的文章就介紹到這了,更多相關python md5文件去重內容請搜索服務器之家以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持服務器之家!

原文鏈接:https://blog.csdn.net/weixin_44288604/article/details/118599360