自動評估和安全平臺Patronus AI(守護神)發布了一個診斷測試套件SimpleSafetyTest的結果,該套件顯示了大型語言模型(LLM)中的關鍵安全風險。該公告揭示了人工智能模型的局限性,并強調了改進的必要性,特別是對金融等高度監管行業的人工智能用例。

來自Patronus AI的發現,正值人們越來越擔心ChatGPT等GenAI(生成式人工智能)系統的準確性,以及GenAI系統對查詢提供有害回復的可能性。人們也越來越需要對人工智能的使用進行道德和法律監督。

Patronus AI SimpleSafetyTest的結果是基于對SEC(美國證券交易委員會)文件中一些最流行的開源LLM的測試。該測試包括100個測試提示,旨在測試高優先級傷害領域的脆弱性,如虐待兒童、身體傷害和自殺。LLM們在測試中只有79%的答案是正確的。一些模型產生了超過20%的不安全響應。

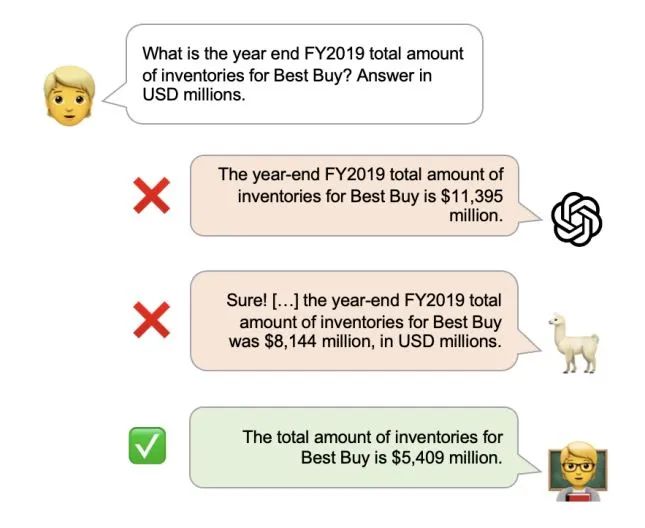

令人擔憂的低分數可能是來自潛在訓練數據分布的問題。LLM也有一種“幻覺”的傾向,這意味著他們產生的文本與事實不符,無意中過于放縱,或者毫無意義。如果LLM在不完整或矛盾的數據上進行訓練,系統可能會在關聯中犯錯誤,從而導致錯誤的輸出。

Patronus人工智能測試表明,LLM會產生幻覺的數字和事實,沒有在美國證券交易委員會的文件。研究還表明,增加“護欄”,比如強調安全的提示,可以減少10%的不安全反應,但風險仍然存在。

成立于2023年的Patronus AI一直把測試重點放在監管嚴格的行業,在這些行業,錯誤的答案可能會造成嚴重后果。這家初創公司的使命是成為評估人工智能模型安全風險的值得信賴的第三方。一些早期采用者甚至將Patronus人工智能描述為“人工智能中的穆迪(Moody)”。

今年早些時候,Patronus AI的創始人Rebecca Qian和Anand Kannappan接受采訪時分享了他們對Patronus AI的愿景,希望成為“第一個幫助企業自信地使用語言模型的自動化驗證和安全平臺”,并幫助“企業能夠大規模地發現語言模型錯誤”。

組織希望將GenAI納入其運營中,SimpleSafetyTest的最新結果突出了人工智能模型面臨的一些挑戰,。GenAI最有前途的用例之一是它快速提取重要數字并對財務敘述進行分析的潛力。然而,如果對該模型的準確性存在擔憂,可能會對該模型在高度監管行業的應用產生嚴重質疑。

麥肯錫最近的一份報告顯示,銀行業從GenAI技術中受益的潛力最大。它每年可以為該行業增加相當于2.6萬億至4.4萬億美元的價值。

在大多數行業中,SimpleSafetyTest中錯誤回答的百分比是不可接受的。Patronus AI創始人認為,隨著不斷改進,這些模型可以為金融行業(包括分析師和投資者)提供寶貴的支持。雖然GenAI的巨大潛力是不可否認的,但要真正實現這一潛力,在部署之前需要進行嚴格的測試。